AI inference to proces, w którym modele sztucznej inteligencji generują odpowiedzi lub przewidywania na podstawie danych wejściowych, takich jak tekst, obrazy czy dźwięki. W przeciwieństwie do etapu trenowania modeli, inference odbywa się na już wytrenowanych sieciach neuronowych i jest kluczowym elementem w codziennym użytkowaniu sztucznej inteligencji. Wyzwanie stanowi optymalizacja tego procesu, aby zapewnić niskie opóźnienia i wysoką wydajność przy jednoczesnym minimalizowaniu kosztów energii oraz zasobów.

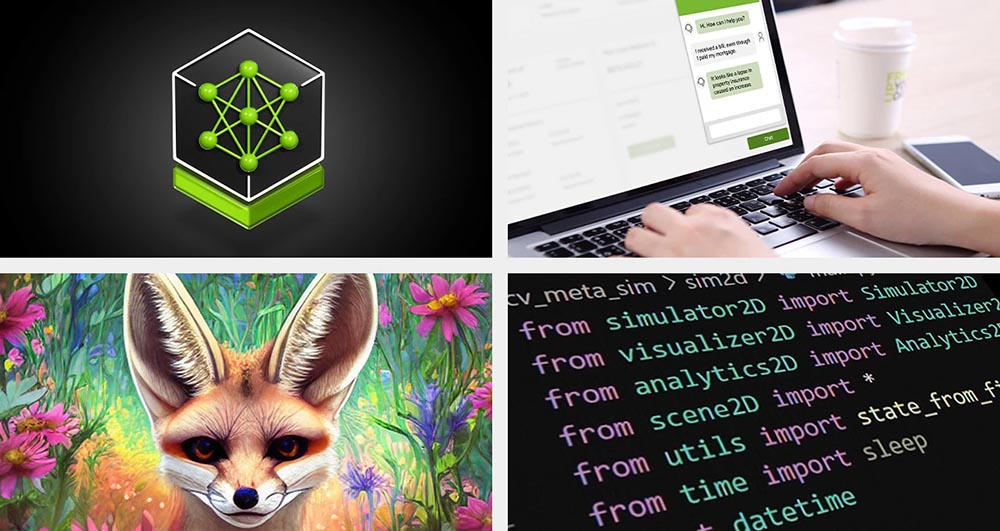

NVIDIA oferuje pełną platformę do inference, która obejmuje zarówno sprzęt, jak i oprogramowanie, umożliwiając firmom szybkie i efektywne wdrożenie rozwiązań AI. Kluczowe technologie takie jak NVIDIA NIM, Triton Inference Server czy TensorRT są fundamentami, które pozwalają na łatwe wdrożenie i optymalizację kosztów.

NVIDIA NIM to mikroserwis, który upraszcza wdrożenie modeli AI w różnych środowiskach – od chmurowych, przez centra danych, aż po stacje robocze. Triton Inference Server to serwer open-source, który obsługuje modele z różnych frameworków, takich jak TensorFlow, PyTorch czy ONNX, umożliwiając łatwą integrację z istniejącymi infrastrukturami IT. TensorRT to biblioteka, która pozwala na niskolatencyjne i wysokowydajne uruchamianie modeli w produkcji, oferując przy tym optymalizację obliczeń.

Platforma inference NVIDIA znajduje zastosowanie w wielu branżach, gdzie AI zyskuje na znaczeniu, zwłaszcza w obliczu rosnącego zapotrzebowania na usługi oparte na modelach językowych (LLM). Przykładami firm, które z powodzeniem wdrożyły rozwiązania NVIDIA, są:

Zoptymalizowana platforma NVIDIA zapewnia nie tylko szybkość i skalowalność, ale także znaczną oszczędność energii. Dzięki technologii Hopper, nowej architekturze GPU, platforma inference NVIDIA osiąga nawet 15-krotną oszczędność energii w porównaniu do poprzednich generacji. Tego typu optymalizacje są kluczowe w dobie rosnących kosztów energii i rosnącego zapotrzebowania na obliczenia AI.

Wdrażając technologie inference od NVIDIA, firmy mogą liczyć na:

W przyszłości, AI inference będzie nadal ewoluować, a połączenie innowacji sprzętowych i oprogramowania od NVIDIA umożliwi dalszy rozwój branży. Dzięki zastosowaniu potężnych procesorów graficznych oraz nowatorskich technik optymalizacji, firmy będą mogły obsługiwać coraz bardziej złożone modele AI w czasie rzeczywistym, przy zachowaniu minimalnych kosztów i niskiego zużycia energii. Przewiduje się, że technologie te staną się jeszcze bardziej powszechne, zyskując zastosowanie w takich dziedzinach jak zdrowie, finanse czy handel detaliczny.

Platforma inference NVIDIA to prawdziwa rewolucja w świecie sztucznej inteligencji. Dzięki niej, firmy mogą nie tylko zoptymalizować swoje koszty i zwiększyć wydajność, ale także dostarczyć użytkownikom lepsze doświadczenia i szybciej reagować na zmieniające się potrzeby rynku. AI jest przyszłością biznesu, a odpowiednia infrastruktura i technologie, takie jak te oferowane przez NVIDIA, są kluczem do sukcesu.