Podczas konferencji GTC firma NVIDIA zaprezentowała NVIDIA Dynamo, nową bibliotekę open-source do przyspieszania i skalowania modeli rozumowania AI. Dynamo zostało stworzone z myślą o maksymalizacji wydajności oraz minimalizacji kosztów obliczeń inference, zwłaszcza w kontekście fabryk AI. Skuteczna koordynacja żądań inferencyjnych na dużej flocie procesorów graficznych jest kluczowa dla optymalizacji kosztów i zwiększania przychodów generowanych przez modele AI. Dzięki NVIDIA Dynamo możliwe jest podwojenie wydajności fabryk AI wykorzystujących modele Llama na obecnej platformie NVIDIA Hopper.

Jak działa NVIDIA Dynamo?

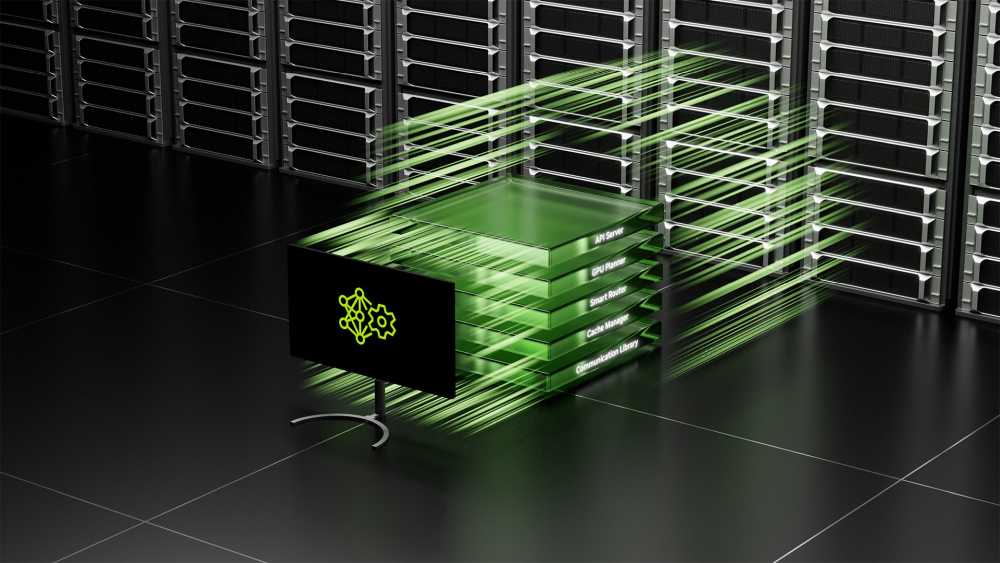

NVIDIA Dynamo to następca Triton Inference Server, zaprojektowany specjalnie do obsługi modeli AI rozumowania. Główne cechy tego systemu obejmują:

- Dysagregowaną obsługę inference – przetwarzanie i generowanie odpowiedzi odbywa się na osobnych procesorach graficznych, co umożliwia ich optymalizację pod kątem specyficznych wymagań.

- Dynamiczną alokację zasobów – system może dodawać, usuwać i rekonfigurować zasoby GPU w zależności od aktualnego obciążenia.

- Zaawansowane techniki routingu – nowy mechanizm mapowania zapytań do odpowiednich GPU skraca czas inferencji, unikając zbędnych obliczeń.

30-krotne przyspieszenie inference na DeepSeek-R1

Na klastrze GB200 NVL72, NVIDIA Dynamo zwiększyło liczbę generowanych tokenów o ponad 30 razy na pojedynczy GPU. To wynik zastosowania inteligentnych optymalizacji, takich jak efektywne zarządzanie pamięcią oraz minimalizacja zbędnych obliczeń.

Przyszłość inference AI

NVIDIA Dynamo będzie dostępne jako open-source i będzie wspierać PyTorch, SGLang, NVIDIA TensorRT-LLM oraz vLLM. Wsparcie dla NVIDIA NIM oraz NVIDIA AI Enterprise zapewni stabilność i produkcyjną jakość rozwiązania.

Dzięki otwartej architekturze i zaawansowanym optymalizacjom NVIDIA Dynamo może stać się kluczowym narzędziem dla firm, które chcą efektywnie skalować swoje modele AI i obniżać koszty ich wdrożenia.