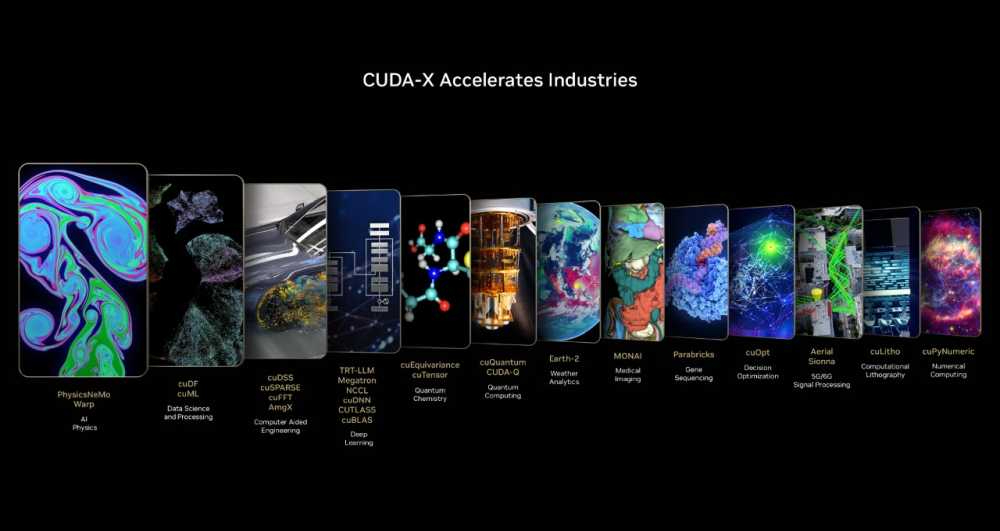

CUDA-X, ogłoszone podczas konferencji NVIDIA GTC, zapewnia automatyczną integrację między CPU i GPU, co skutkuje ogromnym wzrostem wydajności w symulacjach inżynieryjnych, optymalizacji projektów i wielu innych dziedzinach. To kolejny krok w ewolucji obliczeń przyspieszonych, który ułatwia prowadzenie przełomowych badań w takich dziedzinach jak astronomia, fizyka cząstek, fizyka kwantowa, przemysł motoryzacyjny, lotnictwo oraz projektowanie układów scalonych.

Dzięki architekturze Grace CPU NVIDIA znacząco zwiększa przepustowość pamięci przy jednoczesnym zmniejszeniu zużycia energii. Kluczową rolę odgrywa także technologia NVLink-C2C, umożliwiająca bezpośrednią współdzieloną pamięć pomiędzy CPU a GPU. To oznacza, że programiści mogą pisać mniej skomplikowany kod, obsługiwać większe problemy obliczeniowe i uzyskiwać lepszą wydajność aplikacji.

Superchipy NVIDIA pozwalają na jeszcze efektywniejsze wykorzystanie dostępnych zasobów CPU i GPU. Biblioteka cuDSS, zaprojektowana do rozwiązywania dużych problemów symulacyjnych z macierzami rzadkimi, umożliwia przyspieszenie analiz inżynieryjnych, takich jak optymalizacja projektów czy symulacje elektromagnetyczne.

Dzięki pamięci Grace GPU i interfejsowi NVLink-C2C użytkownicy mogą przetwarzać macierze, które wcześniej nie mieściły się w pamięci urządzenia. Przekłada się to na 4-krotne skrócenie czasu rozwiązywania najbardziej wymagających problemów obliczeniowych.

Firmy takie jak Ansys i Altair już wdrożyły cuDSS do swoich narzędzi. Ansys HFSS wykorzystuje cuDSS do przyspieszenia analiz elektromagnetycznych nawet 11-krotnie, a Altair OptiStruct zauważalnie poprawił wydajność swoich obliczeń metodą elementów skończonych.

Architektury GB200 i GH200 otwierają nowe możliwości dla aplikacji ograniczonych dostępnością pamięci. W inżynierii precyzyjne symulacje często wymagają ogromnych zasobów obliczeniowych. Dzięki NVLink-C2C CPU i GPU mogą współdzielić pamięć, eliminując tradycyjne wąskie gardła.

Przykładem jest wykorzystanie NVIDIA Warp – frameworka Python do generowania danych i obliczeń przestrzennych – przez Autodesk. Przy użyciu ośmiu węzłów GH200 przeprowadzono symulacje o skali 48 miliardów komórek, co stanowi ponad 5-krotne zwiększenie w porównaniu do systemów opartych na H100.

Obliczenia kwantowe mają potencjał przyspieszenia wielu kluczowych problemów naukowych i przemysłowych. Jednak rozwój tej technologii zależy od symulacji skomplikowanych układów kwantowych. Biblioteka cuQuantum umożliwia efektywne modelowanie takich układów, obsługując zarówno symulacje wektorów stanów, jak i sieci tensorowych.

Dzięki GB200 i GH200 można skalować te symulacje w sposób wcześniej niemożliwy. W testach benchmarkowych system GH200 osiągnął do 3 razy wyższą wydajność w porównaniu do systemu H100 opartego na architekturze x86.

Od czasu premiery CUDA w 2006 roku NVIDIA zbudowała ponad 900 specjalistycznych bibliotek CUDA-X i modeli AI, otwierając nowe możliwości dla wielu dziedzin nauki i inżynierii. CUDA-X z superchipami GH200 i GB200 to kolejny krok w rewolucji obliczeniowej, który pozwala naukowcom i inżynierom szybciej osiągać przełomowe wyniki i rozwiązywać problemy o niespotykanej dotąd skali.